量子模拟迎来GPU革命:英伟达新武器实现14倍加速,碾压传统CPU

量子模拟迎来GPU革命:英伟达新武器实现14倍加速,碾压传统CPU

在量子计算这个充满未来感的领域,科学家们并非直接在一台真正的量子计算机上编写代码。他们更多地依赖一种至关重要的工具——量子计算机模拟器。它就像是一个"量子沙盒",让研究人员能够在经典的计算机上设计、测试和验证量子算法与硬件。

然而,一个巨大的挑战横亘在面前:模拟量子系统需要消耗的计算资源,随着量子比特数量的增加呈指数级爆炸。这严重限制了我们可以模拟的量子电路规模和复杂度。

那么,如何才能打破这个枷锁,让量子研究的"沙盒"变得更大、运行得更快?一项来自瑞典皇家理工学院的最新研究给出了一个清晰而有力的答案:GPU,正是加速量子模拟的关键钥匙。

项目简介:为量子模拟装上"超级引擎"

本研究聚焦于一个核心问题:GPU能否成为加速量子计算机模拟的关键赋能技术?

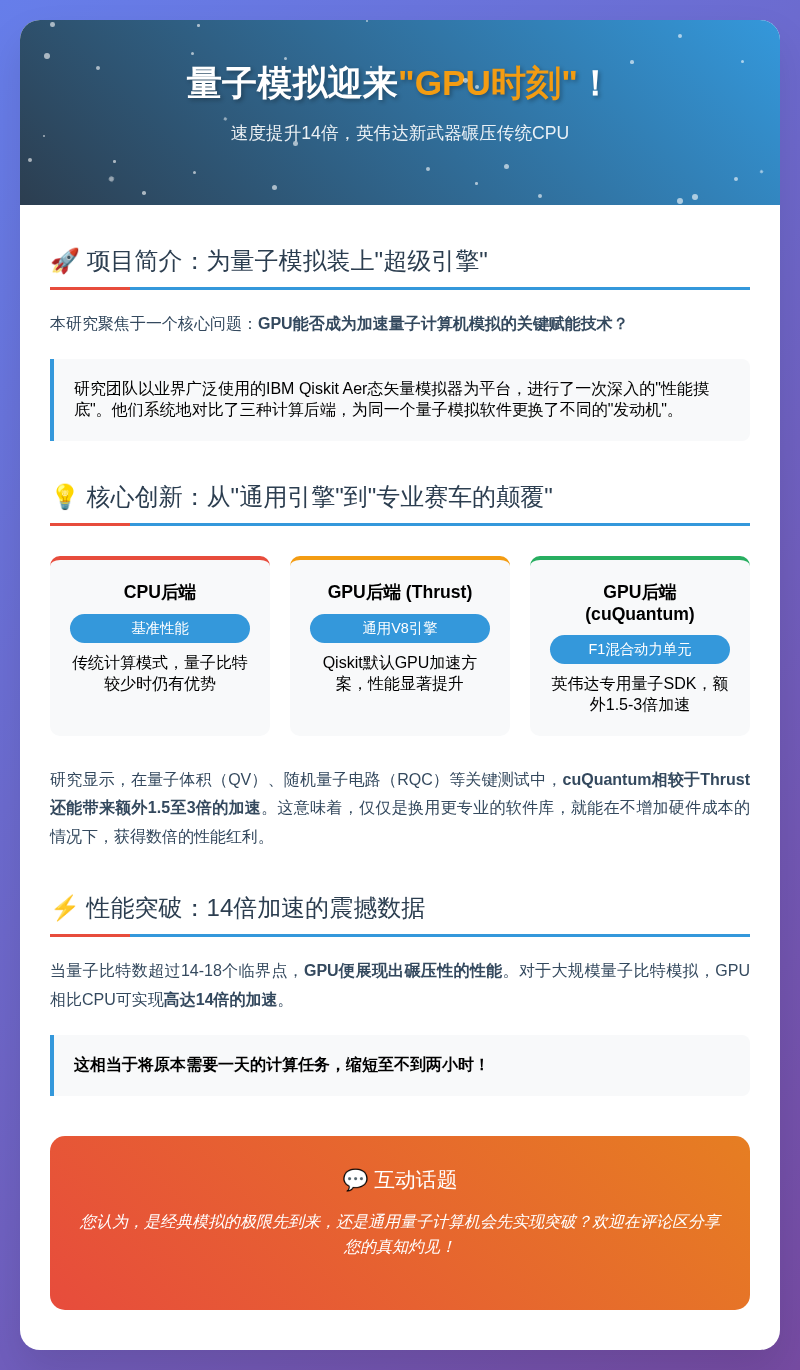

研究团队以业界广泛使用的IBM Qiskit Aer态矢量模拟器为平台,进行了一次深入的"性能摸底"。他们系统地对比了三种计算后端:

- CPU后端:传统计算模式。

- GPU后端(Nvidia Thrust):Qiskit默认的GPU加速方案。

- GPU后端(Nvidia cuQuantum):英伟达新推出的专为量子计算优化的SDK。

简单来说,这项研究就是为同一个量子模拟软件(Qiskit Aer)更换了不同的"发动机"(CPU、通用GPU引擎、专用量子GPU引擎),然后在各种复杂的量子"路况"(不同量子应用)下,测试它们的极限性能。

核心创新:从"通用引擎"到"专业赛车的颠覆"

这项研究最引人注目的,并非仅仅证实了GPU比CPU快,而是它清晰地揭示了专用优化工具带来的巨大飞跃。

从CPU到GPU:量变到质变的跨越

当量子比特数较少时,CPU因其低开销仍有优势。但一旦量子比特数超过14-18个临界点,GPU便展现出碾压性的性能。对于大规模量子比特模拟,GPU相比CPU可实现高达14倍的加速。这相当于将原本需要一天的计算任务,缩短至不到两小时。

从Thrust到cuQuantum:从"好用"到"神器"的进化

如果说默认的Thrust后端是给量子模拟装上了一台强大的"通用V8引擎",那么cuQuantum就是一台为量子计算量身定制的"F1混合动力单元"。

研究显示,在量子体积(QV)、随机量子电路(RQC)等关键测试中,cuQuantum相较于Thrust还能带来额外1.5至3倍的加速。这意味着,仅仅是换用更专业的软件库,就能在不增加硬件成本的情况下,获得数倍的性能红利。

机制解析:GPU为何是"天作之合"?

量子态矢量模拟的本质,是跟踪一个由复数构成的巨大数组的演化。每一次量子门操作,都相当于对这个巨大数组进行一系列矩阵乘法运算。

- GPU的并行优势:矩阵乘法蕴含大量可以同时进行的计算,这正好命中GPU(图形处理器)最擅长的领域——大规模并行计算。CPU像是一位博学的教授,能快速处理复杂任务;而GPU则像一支纪律严明的军队,擅长同时完成海量简单指令。

- cuQuantum的"秘密武器":作为专为量子计算打造的SDK,cuQuantum对底层计算内核进行了极致优化。研究表明,它能更高效地压榨GPU的计算单元和内存带宽,使其更接近GPU的理论性能峰值,从而实现了对通用Thrust库的超越。

优势与机遇:推开更大规模量子研究的大门

这项研究的成果,为整个量子计算领域带来了切实的利好:

- 加速算法研发:更快的模拟速度意味着研究人员能在相同时间内测试更多算法创意,大幅缩短研发周期。

- 推动硬件设计:在构建真实的量子计算机之前,工程师可以利用GPU模拟来验证设计方案,优化硬件参数。

- 降低研究门槛:强大的单机GPU模拟能力,使得更多学术机构和小型团队能够参与到前沿量子研究中,而不必完全依赖昂贵的超级计算机。

- 明确技术路线:它强有力地证明了,基于GPU的加速方案是当前扩展量子模拟能力最有效、最可行的路径之一。

挑战与风险:前方的"拦路虎"不容小觑

尽管前景光明,但通往大规模量子模拟的道路上依然布满荆棘:

- 指数级内存墙:这是态矢量模拟器的"原罪"。模拟N个量子比特需要2^N个复数元素。研究指出,即便是顶级的多GPU系统,目前也只能将模拟规模推到50个量子比特左右。指数增长的记忆需求,是最终极的瓶颈。

- 多GPU通信开销:当模拟任务被分配到多个GPU上时,GPU之间以及主机与GPU之间的数据迁移成为了新的主要瓶颈。研究发现,在双GPU实验中,数据通信耗时占比超过90%,严重拖累了计算效率。

- 技术依赖风险:当前量子模拟的GPU加速生态严重依赖英伟达一家(CUDA、Thrust、cuQuantum)。这种技术栈的集中性可能带来潜在风险。

结尾:这是我们想要的未来吗?

这项研究无疑为量子计算的发展注入了一剂强心针。它告诉我们,在等待通用量子计算机这座"圣杯"降临的漫长岁月里,我们远非无所事事。通过巧妙地利用经典计算中最强大的GPU技术,我们正在不断拓展人类理解和操控量子世界的边界。

然而,它也抛出了一个更深层的问题:当量子模拟的规模逼近经典计算的极限,我们下一步该走向何方?

是继续投入巨资,建造更庞大的超级计算机来"硬扛"指数增长?还是将希望寄托于张量网络、费曼路径积分等更节省内存的新模拟算法?抑或是,量子硬件本身的突破会突然到来,让所有这些经典的模拟努力都成为一段历史?

GPU已经为我们赢得了宝贵的时间和空间。但关于计算的终极未来,这场伟大的探索,才刚刚开始。

本文资料引用自:https://arxiv.org/abs/2307.14860